全部案例

- 医疗行业

- 金融保险

- 教育行业

- 媒体行业

- 政府/企业

- IC芯片

英伟达又出手啦?发布超级芯片!

发布时间:2024-11-21

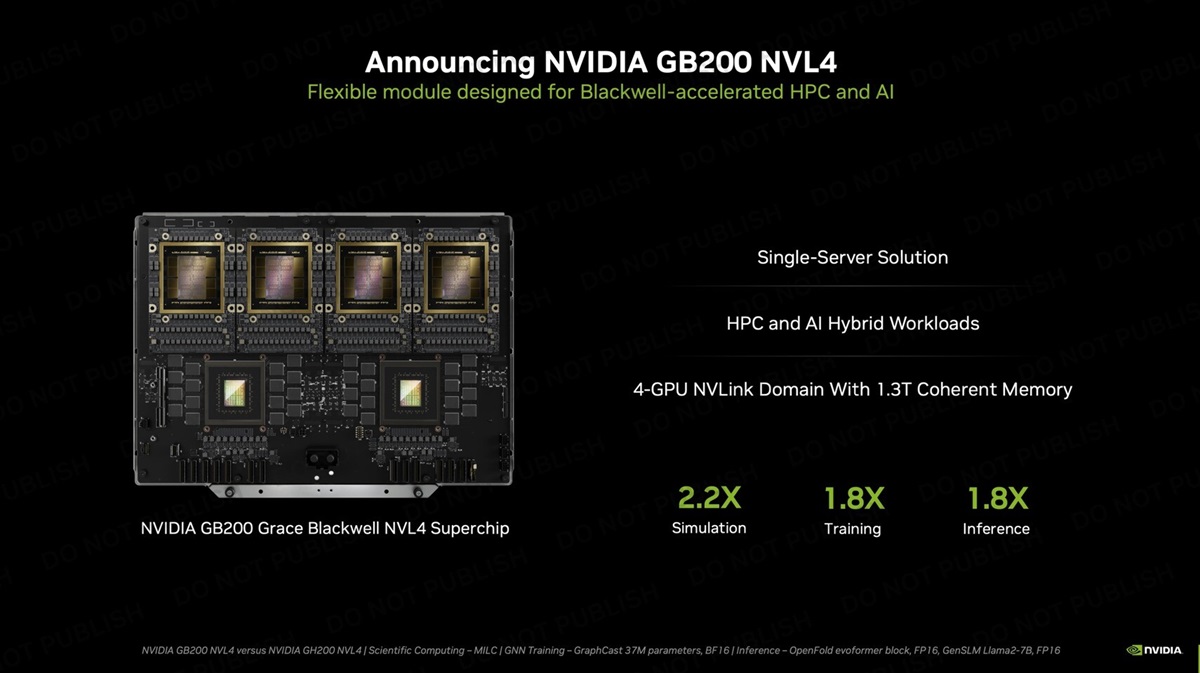

在2024年超算大会(SC24)上,英伟达公布了两款最新的AI硬件产品——GB200 NVL4超级芯片及H200 NVL PCIe模块,用于运行AI工作负载的企业服务器,以满足高性能计算(HPC)和人工智能(AI)工作负载的需求。

GB200 NVL4超级芯片是英伟达迄今为止最大的AI“芯片”,它是一个单服务器解决方案,集成了4个Blackwell GPU和2个Grace CPU,通过NVLink互连技术实现高速通信。不仅如此,这款芯片配备了高达768GB的HBM3E及960GB的LPDDR5X内存,提供了32TB/s的组合内存带宽,足以应对各类复杂AI任务。

在性能方面,该芯片表现优异,在模拟仿真性能、AI训练性能及AI推断性能方面均较GH200 NVL4有所提升,分别达到了2.2倍、1.8倍及1.8倍。同时,这款超级芯片的功耗为5400W,配备了液冷散热系统,预计将被部署在超大规模客户的服务器机架中,符合当下数据中心液冷方案的发展趋势。

H200 NVL PCIe模块属于Hopper系列,专为数据中心设计,能够在更小的空间内提供更多的计算能力,同时降低功耗以提高能源效率。相较于与前代产品H100 NVL,H200 NVL的内存提升至前代的1.5倍,带宽增加了1.2倍,大语言模型推理性能最高可提升1.7倍,HPC工作负载性能提升了1.3倍。H200 NVL PCIe模块为双槽厚度,TDP为600W,比H200 SXM的700W更为环保节能。

虽然INT8 Tensor Core算力略有下降(约15.6%),但H200 NVL仍然支持双路或四路的900GB/s NVLink互联。H200 NVL的显存容量是H100 NVL的1.5倍,带宽达到前代的1.2倍,AI推理性能提升了1.7倍,在HPC应用中性能也高出30%。

预计于下月开始,搭载H200 NVL的平台将会持续推出市场应用。除此之外,H200 NVL还能广泛适配多家服务器制造商的平台,为广大数据中心的用户提供更多选择。

这两款新产品的发布,标志着英伟达在AI和HPC领域的进一步扩展,为数据中心客户提供了更强大的计算能力和更高的能源效率。随着这些产品的推出,英伟达继续巩固其在AI芯片市场的领导地位。

资讯来源:https://www.crn.com/news/components-peripherals/2024/nvidia-reveals-4-gpu-gb200-nvl4-superchip-releases-h200-nvl-module